文|tech说唐嫣 白虎

1974年,我国的考古学家在陕西省西安市发掘出了戎马俑,并被其心绪差异惟妙惟肖的面部表情所触动。同庚,一篇名为《A Parametric Model for Human Faces》论文迈出了东说念主脸属性剪辑这一领域的第一步。

而半个世纪后的今天,BIGO自主研发的FaceMagic的换脸时期让你独揽清静地化身为戎马俑,天下名画,或者电影里的超等勇士, 居品一推出即风靡环球。

时期挑战主要来源于三个方面:第一是东说念主脸特征迁良晌间,咱们更动性地尝试把格调移动的念念路用于东说念主脸特征移动中,克服了那时主流的deep fake、 3D决议等时期的不及。 第二是环球化问题,因为BIGO用户来源于环球各地,为了惩处不同东说念主种的肤色、五官结构的差异问题,咱们构建了千万量级的环球化的东说念主脸数据集,极地面涵盖肤色、性别、年齿等差异性,努力把环球每一位用户的后果作念到最好 。

第三是多属性,多场景的后果优化,咱们在不断优化蚁集结构的同期尝试东说念主脸属性、东说念主脸姿态等管理,并放肆普及大领域数据的历练遵循,充分挖掘数据的各类性特征,把换脸后果作念到愈加鲁棒、实在、天然。

FaceMagic仍在眩惑越来越多东说念主的参与,自上线以来,环球分娩总量接近1亿。功能推出后,每天有跳动百万级的内容分娩量。

配景

东说念主脸属性剪辑是筹划机视觉领域的一项进击时期,庸碌用于内容分娩,电影制作,文娱视频中。早期的东说念主脸属性剪辑主要会聚在东说念主脸的表情上,比如通过修改张嘴或者闭眼来体现东说念主的喜怒无常。

跟着算力的普及,这项时期随后便升华为即时的表情剪辑或移动,也就是将一张脸的表情作为输入,来甘休另一张脸的表情作为输出,当下咱们看到的三维动画或者捏造偶像都在庸碌地讹诈这项时期。

关系词只是换个表情赫然仍是跟不上科研东说念主员的脑洞,Volker 一转东说念主在论文《Exchanging faces in images》[1]中初度提议了在天然图像中置换东说念主脸的见解。著作中使用了一种较为原始的3D模子决议来粗估姿态与色泽,并将琢磨东说念主脸替换至源东说念主脸上。这项时期由于需要东说念主工参与标定关节点,主要被应用于图像剪辑等责任。在漫长的学术发展过程中,换脸时期发生了天翻地覆的变化,迟缓养殖出来了基于3D脸部建模,以及抗拒生成蚁集(GAN) [2]的两个流派。

3D脸部建模的决议比较直不雅,即先对源图片和琢磨图片进行关节点检测并进行3D建模,然后索要琢磨图片中的身份信息(ID)替换源图片中的相应部分。Dmitri Bitouk et al.[3]针对[1]中需要进行东说念主工参与,同期也不行处理表情的问题,提议了一个全新的决议,不错惩处自动化以及表情的问题。

而近代通过3D建模来杀青换脸的鼻祖,Face2Face [4]则通过拟合一个3DMM[5]模子来进一步移动表情。作为第一个能及时进行面部治愈的模子,Face2Face的准确率和实在度建立了业界标杆 。

随后的一些琢磨也多基于此,对生成东说念主脸的天然度进行强化,举例Suwajanakorn et al.[6]对嘴部的模子进行修正,使得嘴部的动作愈加天然。Nirkin et al.[7]团结脸部分割,基于一个固定的三维东说念主脸来进行换脸,幸免拟合三维东说念主脸模式。这些递次虽然能取得一定的换脸后果,可是要么筹划量太大,要么就是生成换脸后的图片依旧不天然,且很难处理讳饰等问题。

连年来,跟着大领域的GPGPU算力的出现,基于GAN的换脸决议异军突起,一举击破了基于传统3D换脸决议的大本营。这个冲突最初出当今Pix2pixHD [8]中,Ting-Chun等东说念主使用了一个多表率的cGAN结构进行图片对图片的变化,举例给定一个脸部的综合信息,cGAN则能将其出动成一个实在东说念主脸。

紧接着GANimation[9] 提议一个双分支生成器来惩处东说念主脸表情的问题,其中一个分支通过追思防御力争来甘休表情,另一个分支则提供配景和色泽信息。GANnotation [10]则在添加管理要求的说念路上更进一步,通过管理东说念主脸关节点来驱动生成对应的东说念主脸。除此之外,琢磨者们也在尝试着与传统决议团结,亦或通过先验常识来指令GAN的生成质料。

Kim等东说念主在 Deep video portraits [11] 团结了传统3D与GAN的时期来进行东说念主脸的生成;RSGAN [12]提议一种解耦脸部和头发的递次来换脸;FSGAN [13]通过团结脸部分割来评估讳饰区域,在一定进度上惩处了换脸当中的讳饰问题。基于GAN的递次生成的换脸图片比拟3D递次愈加实在天然,可是很难产生高清的换脸后果,另外源图片姿态比较大时很难兼顾姿态的一致性和换脸的ID移出发手。

BIGO的算法团队经过探索,提议了基于格调移动+ID注入的FaceMagic决议,在生成高清天然东说念主脸的同期简略保握东说念主脸姿态、属性一致。现时FaceMagic已在线上运营,逐日用户使用量过百万级。

格调移动的风起

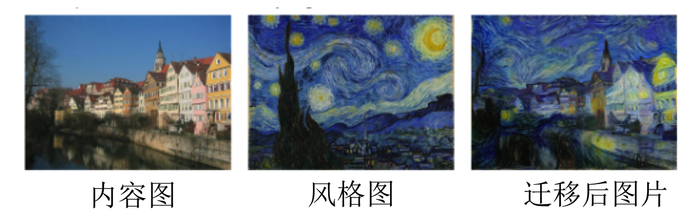

这一切要从格调移动(Neural Style Transfer)的琢磨端倪讲起。2016年ECCV的一篇《Image Style Transfer Using Convolutional Neural Networks》[14] 给一张阿姆斯特丹的状态照加上了星空的嗅觉。

著作提议的基于Gram matrix的递次,也就是神经蚁集的特征图各个通说念的关系性,将实在图片(content)与格调图片(style)交融。这使得合成后的图片具有原始图片的内涵,可是视觉上又会感受到不同样的格调。

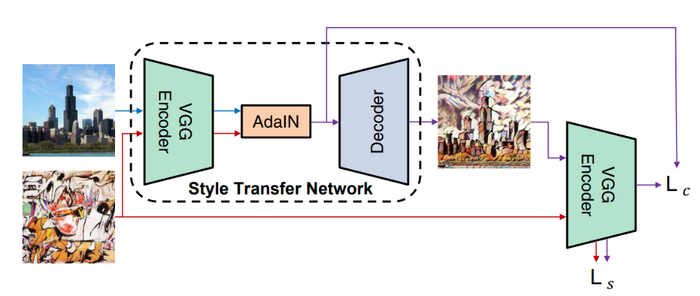

天然,这种决议的代价亦然精深的,每一组不同的content到style的治愈,都需要历练一个专用的神经蚁集,这在执行的应用当中赫然是不现实的。2017年的另一篇论文《Arbitrary Style Transfer in Real-time with Adaptive Instance Normalization》(AdaIN)[15]则对此问题作念出了回复。这篇著作阐发了一个至关进击的论断:style信息荫藏在特征层中每一层的统计量中(也就是每一层的均值μ和轨范差σ)。

天天自拍在线故而,著作通过定向改革Instance Normalization(IN)层后特征的均值以及轨范差,来获取格调移动后果。这个递次唯有通过历练一次蚁集,即不错杀青轻易content至轻易style的格调移动。

把东说念主脸作为念一种格调

2019年英伟达发表了论文《A Style-Based Generator Architecture for GAN》[16],也就是大名鼎鼎的StyleGAN,这种蚁集赶走生成最高1024*1024分辨率的东说念主脸,且终点的实在与天然,惊艳全场。而这背后的中枢,则是通过深层全麇集神经蚁集,将一组马上编码的向量出动成一组均值μ和轨范差σ,再送入不同表率的AdaIN模块,最毕生成高清东说念主脸。

StyleGAN的责任给咱们带来的不仅是新的蚁集结构、历练递次唐嫣 白虎,更进击的是念念维上的颠覆:“东说念主脸特征也不错作为一种格调来刻画”。那么,到底什么是content, 什么是style?

在艺术格调移动中,content 作为实在像片中的什物模式、综合,style则是艺术家画作中的颜色、笔触、画风等特有的艺术特色。

在StyleGAN中,则莫得content,一切的东说念主脸特征都为style。从这个角度再行注视格调移动,咱们会得出论断:关于content跟style的界定,莫得结伙的轨范,澈底取决于你何如永别!应用时,需要保留的部分作为content,而需要改革的部分则作为style。

从格调移动到换脸

咱们再一次回到换脸这个话题,StyleGAN在生成东说念主脸的时刻,使用了马上编码的向量作为种子,生成了所需的东说念主脸style,那么咱们可否使用肖似的念念想,抽取琢磨东说念主脸的style,用来替换源东说念主脸的呢?谜底天然是信服的。

接下来咱们将通过四步演化过程来推崇咱们的FaceMagic模子:1)化我为我;2)化我为他;3)融于你我;4)止于均衡。

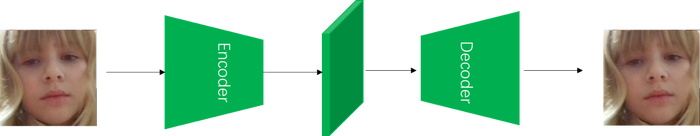

化我为我

算法的第一步天然是信服咱们的content,也就是面部姿态与表情等属性信息,这个琢磨咱们通过让模子学会生成我方来达成。悉数这个词过程接纳了如图3所示的经典Encoder-Decoder结构,蚁集的输入输出为归拢张东说念主脸图像I,通过相易了多层的ResBlock结构的Encoder,获取特征图F。引申上咱们接纳了较大的d值来保存更多的content信息。

化我为他

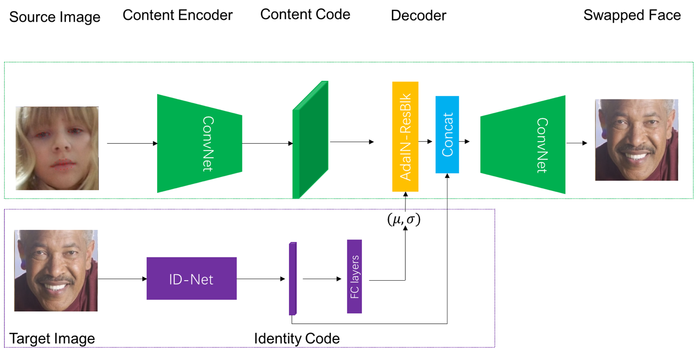

当模子信服了源东说念主脸中的content信息,咱们下一步的琢磨即是将琢磨东说念主脸的ID信息,以style的时局注入至content当中。这个琢磨不错进一步拆解为琢磨东说念主脸的ID索要以及注入两步。ID索要部分,咱们借用了使用VGG-Face[17]数据集预历练的东说念主脸识别蚁集ID-Net。

通过ID-Net索要的特征向量G简略很好地区分东说念主脸之间的相似进度,因此不错很紧致地表征一个东说念主的身份特征,同期不会引入其他打扰信息。而在至关进击的信息注入部分,咱们的基本念念路,则是最初通过全麇集层,将琢磨东说念主脸的G_Tar出动为所需的均值与方差μ_Tar,σ_Tar,再依照AdaIN的样式将style注入content。

关系词在执行操作中,咱们防御到了以下两个问题:I)历练蚁集时的拘谨速率很慢;II)容易产生东说念主工形成的不天然颓势(artifacts)。

这两个问题让咱们再行反念念换脸问题的执行:琢磨东说念主脸的ID天然不错按照style的念念路注入源东说念主脸的content中,可是这种决议很肖似于传统的2D/3D视觉中的“贴脸”政策——澈底接纳琢磨东说念主脸的ID信息而烧毁源东说念主脸的;而要达成“换脸”,咱们执行上只需要热心一个从琢磨东说念主脸的ID到源东说念主脸ID信息的变化。

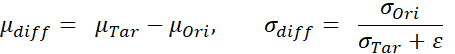

于是,咱们再行界说了要注入进AdaIN的style为“信息增量”,如下式所示:

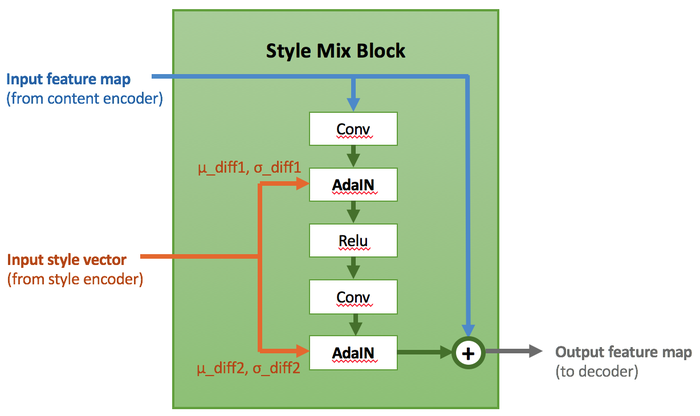

其中ε是一个较小的量以踏实数值。依照这个念念路,咱们瞎想了基于AdaIN-ResBlock的格调交融模块Style Mix Block,在多个空间表率上将ID的信息增量通过AdaIN注入至从源东说念主脸中抽取的content当中。

咱们另外也接纳了一种基于信息增量的历练模式:通过混入一部分源与琢磨东说念主脸为归拢张图片的历练数据,使注入的style信息恒定为μ_diff =0,σ_diff = 1。这个决议极地面提高了模子在学习重构失掉机的拘谨速率,况且阻拦了大部分因为“贴脸重构”导致的artifacts。图4为Style Mix Block的详确结构。

关系词到这里,BIGO算法团队对琢磨东说念主脸的ID注入决议的念念考,依旧莫得赶走。实在场景中的换脸,原东说念主脸以及琢磨东说念主脸信服不会像证件照同样整洁轨范,而时时会波及到大表率上的pose治愈或者被帽子眼镜讳饰的情况。

在这种情况下,信息增量本人存在一个不准确的问题,这就会导致一个在执行后果中依旧存在“换脸的赶走并不像琢磨东说念主脸”的情况。在经过强烈的参谋之后,咱们作念了一个斗胆的决定:将原始用来刻画ID信息的特征G,平直拼接(Concatenate)到Style Mix Block的特征上,并将这个全体特征送入Decoder来生成最终赶走。全体蚁集构架如图5所示。

融于你我

故事讲到这里,却依旧只是个起首,接下来一个问题出来那处呢?

这就攀扯到抗拒生成蚁集的一些执行了,咱们常说,抗拒生成蚁集实质上是学习了实在样本的特征流形,在生成的时刻通过中式一组作为种子的马上变量,中式流形上的点并映射到图像空间上。这就导致了,咱们虽然不错保证一张生成的图像“实在且天然”,可是却难以保证在一连串的视频帧上的连气儿性。

举例,在大表率上的pose治愈的场景下,很容易出现提供content的源东说念主脸的pose信息“丢失”的情况;另外源东说念主脸的ID信息在视频中本人也会存在扰动,而这些扰动由会被注入操作进一步放大。这些情况都导致了在对视频进行按帧换脸的操作时,会产生姿态舞动或者肤色光照抖动等不连气儿的情况。

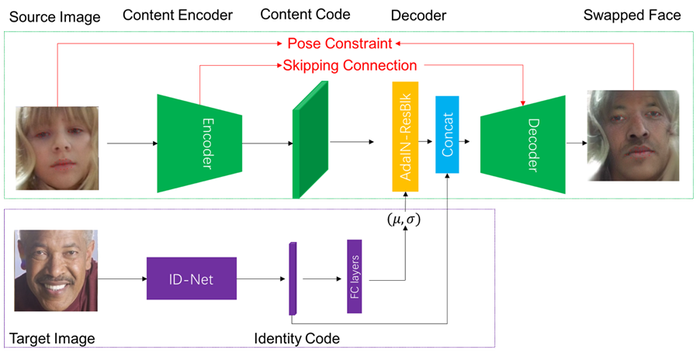

这里咱们通过Pose Constraint以及Skipping connection来缓解视频换脸中存在的连气儿性问题,如图6红色部分所示:

1)Pose Constraint:咱们通过脸部的landmark来强管理源东说念主脸以及生成东说念主脸之间pose差异的问题。这么即便源东说念主脸在某些帧出现大表率的pose治愈,生成的也依旧会被管理在源东说念主脸的pose上。

2)Skipping Connection:为了让生成的图片简略踏实的保留源图片的特征,咱们尝试将一些Encoder的低档次的特征平直通过Skipping Connection平直植入到Decoder的特征当中。

止于均衡

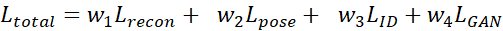

咱们先作念一个小总结,现时咱们有了许多的模块,咱们的total loss不错写成底下的时局:

很赫然,加大L_recon和L_pose的权重,不错使得生成的东说念主脸能更多地保留源东说念主脸的特征,加大L_ID的权重,则会更多地移动更多琢磨的身份特征,L_GAN的权重则用于保证生成的东说念主脸尽可能的实在天然。那么,终于,咱们不错运转本旨地去调参数了?

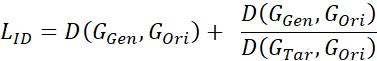

赫然,终极的均衡不是调参就不错赢得的。BIGO的算法同学在深挖了L_ID后发现:关于两个原来长得就有点像的东说念主,换脸后的赶走从视觉上果真看不出变化,原因在于他们的ID特征距离原来就小,若是只是使用粗浅的l2失掉或者cos相似度的话,蚁集对这部分的处分会很小,可是粗浅的加大L_ID的权值又会使悉数这个词蚁集的历练变得长途。为了惩处这个问题,咱们提议了估计换脸后果的相对ID距离。粗浅来说,就是对比源东说念主脸在换脸前后与琢磨东说念主脸的距离差异。用公式不错抒发为:

其中,为l2失掉或者cos相似度。式子的前半部分为原始的ID信息失掉,后半部分为对比失掉。

参考文件

1. Volker Blanz, Kristina Scherbaum, Thomas Vetter, and Hans-Peter Seidel. Exchanging faces in images. In Computer Graphics Forum, volume 23, pages 669–676. Wiley Online Library, 2004. 1, 2, 3

2. Ian Goodfellow, Jean Pouget-Abadie, Mehdi Mirza, Bing Xu, David Warde-Farley, Sherjil Ozair, Aaron Courville, and Yoshua Bengio. Generative adversarial nets. In Advances in neural information processing systems (NPIS), pages 2672–2680, 2014.

3. Dmitri Bitouk, Neeraj Kumar, Samreen Dhillon, Peter Belhumeur, and Shree K Nayar. Face swapping: automatically replacing faces in photographs. ACM Trans. on Graphics (TOG), 27(3):39, 2008.

4. Justus Thies, Michael Zollhofer, Marc Stamminger, Chris- tian Theobalt, and Matthias Nießner. Face2face: Real-time face capture and reenactment of rgb videos. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), pages 2387–2395, 2016.

5. Volker Blanz, Sami Romdhani, and Thomas Vetter. Face identification across different poses and illuminations with a 3d morphable model. In Int. Conf. on Automatic Face and Gesture Recognition (FG), pages 192–197, 2002.

6.Supasorn Suwajanakorn, Steven M Seitz, and Ira Kemelmacher-Shlizerman. Synthesizing obama: learning lip sync from audio. ACM Transactions on Graphics (TOG), 36(4):95, 2017.

7. Yuval Nirkin, Iacopo Masi, Anh Tran Tuan, Tal Hassner, and Gerard Medioni. On face segmentation, face swapping, and face perception. In Automatic Face & Gesture Recognition (FG), 2018 13th IEEE International Conference on, pages 98–105. IEEE, 2018.

8. Ting-Chun Wang, Ming-Yu Liu, Jun-Yan Zhu, Andrew Tao, Jan Kautz, and Bryan Catanzaro. High-resolution image synthesis and semantic manipulation with conditional gans. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2018.

9. Albert Pumarola, Antonio Agudo, Aleix M Martinez, Al- berto Sanfeliu, and Francesc Moreno-Noguer. Ganimation: Anatomically-aware facial animation from a single image. In Proceedings of the European Conference on Computer Vision (ECCV), pages 818–833, 2018.

10. Enrique Sanchez and Michel Valstar. Triple consistency loss for pairing distributions in gan-based face synthesis. arXiv preprint arXiv:1811.03492, 2018.

11. Hyeongwoo Kim, Pablo Carrido, Ayush Tewari, Weipeng Xu, Justus Thies, Matthias Niessner, Patrick Pe ́rez, Chris- tian Richardt, Michael Zollho ̈fer, and Christian Theobalt. Deep video portraits. ACM Transactions on Graphics (TOG), 37(4):163, 2018.

12. Ryota Natsume, Tatsuya Yatagawa, and Shigeo Morishima. Rsgan: face swapping and editing using face and hair representation in latent spaces. arXiv preprint arXiv:1804.03447, 2018.

13. Nirkin Y, Keller Y, Hassner T. Fsgan: Subject agnostic face swapping and reenactment. In Proceedings of the IEEE International Conference on Computer Vision (ICCV). 2019: 7184-7193.

14. Gatys L A, Ecker A S, Bethge M. Image style transfer using convolutional neural networks. In Proceedings of the IEEE conference on computer vision and pattern recognition (CVPR). 2016: 2414-2423.

15. Huang X, Belongie S. Arbitrary style transfer in real-time with adaptive instance normalization. In Proceedings of the IEEE International Conference on Computer Vision (ICCV). 2017: 1501-1510.

16. Karras T, Laine S, Aila T. A style-based generator architecture for generative adversarial networks. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR). 2019: 4401-4410.

17. Parkhi O M唐嫣 白虎, Vedaldi A, Zisserman A. Deep face recognition[J]. 2015.